หน่วยประมวลผลประสาท (NPU) คืออะไร?

หน่วยประมวลผลประสาท (NPU) คือไมโครโปรเซสเซอร์คอมพิวเตอร์เฉพาะทางที่ออกแบบมาเพื่อเลียนแบบฟังก์ชันการประมวลผลของสมองมนุษย์ NPU ได้รับการปรับให้เหมาะสมสำหรับ เครือข่ายประสาทเทียม (AI) การเรียนรู้เชิงลึก และ งานและแอปพลิเคชันการเรียนรู้ของเครื่อง

NPU แตกต่างจากหน่วยประมวลผลกลาง (CPU) ทั่วไปหรือหน่วยประมวลผลกราฟิก (GPU) โดยได้รับการปรับแต่งมาเพื่อเร่งความเร็วในงานและปริมาณงานของ AI เช่น การคำนวณชั้นเครือข่ายประสาทที่ประกอบด้วยคณิตศาสตร์แบบสเกลาร์ เวกเตอร์ และเทนเซอร์

NPU หรือที่รู้จักกันในชื่อ ชิป AI หรือ ตัวเร่งความเร็ว AIมักใช้ในสถาปัตยกรรมการประมวลผลแบบเฮเทอโรจีเนียสที่รวมโปรเซสเซอร์หลายตัว (เช่น CPU และ GPU) ศูนย์ข้อมูล ขนาดใหญ่ สามารถใช้ NPU แบบสแตนด์อโลนที่เชื่อมต่อโดยตรงกับเมนบอร์ดของระบบ อย่างไรก็ตาม แอปพลิเคชันสำหรับผู้บริโภคส่วนใหญ่ เช่น สมาร์ทโฟน อุปกรณ์พกพา และแล็ปท็อป มักจะรวม NPU เข้ากับโคโปรเซสเซอร์อื่นๆ บนไมโครชิปเซมิคอนดักเตอร์ตัวเดียวที่เรียกว่า system-on-chip (SoC)

ด้วยการบูรณาการ NPU เฉพาะทาง ผู้ผลิตจึงสามารถนำเสนอแอป AI เชิงสร้างสรรค์บนอุปกรณ์ที่สามารถประมวลผลแอปพลิเคชัน AI เวิร์กโหลด AI และอัลกอริทึมการเรียนรู้ของเครื่องแบบเรียลไทม์ด้วยการใช้พลังงานที่ค่อนข้างต่ำและปริมาณงานสูง

คุณสมบัติหลักของ NPU

หน่วยประมวลผลประสาท (NPU) เหมาะอย่างยิ่งสำหรับงานที่ต้องใช้ การประมวลผลแบบขนาน ที่มีเวลาแฝงต่ำ เช่น การประมวลผลอัลกอริทึมการเรียนรู้เชิงลึก การจดจำเสียงพูดการ ประมวลผลภาษาธรรมชาติการประมวลผลภาพถ่ายและวิดีโอ และ การ ตรวจจับวัตถุ

คุณสมบัติหลักของ NPU มีดังต่อไปนี้:

- การประมวลผลแบบขนาน: NPU สามารถแบ่งปัญหาใหญ่ๆ ออกเป็นส่วนประกอบต่างๆ เพื่อแก้ปัญหาแบบมัลติทาสก์ ซึ่งช่วยให้โปรเซสเซอร์สามารถรันการทำงานเครือข่ายประสาทได้หลายรายการพร้อมกัน

- เลขคณิตความแม่นยำต่ำ: NPU มักรองรับการทำงาน 8 บิต (หรือต่ำกว่า) เพื่อลดความซับซ้อนในการคำนวณและเพิ่มประสิทธิภาพด้านพลังงาน

- หน่วยความจำแบนด์วิดท์สูง: NPU จำนวนมากมีหน่วยความจำแบนด์วิดท์สูงบนชิปเพื่อดำเนินการประมวลผล AI ที่ต้องการชุดข้อมูลขนาดใหญ่ได้อย่างมีประสิทธิภาพ

- การเร่งความเร็วด้วยฮาร์ดแวร์: ความก้าวหน้าในการออกแบบ NPU นำไปสู่การรวมเทคนิคการเร่งความเร็วด้วยฮาร์ดแวร์ เช่น สถาปัตยกรรมอาร์เรย์ซิสโตลิกหรือการประมวลผลเทนเซอร์ที่ได้รับการปรับปรุง

NPU ทำงานอย่างไร

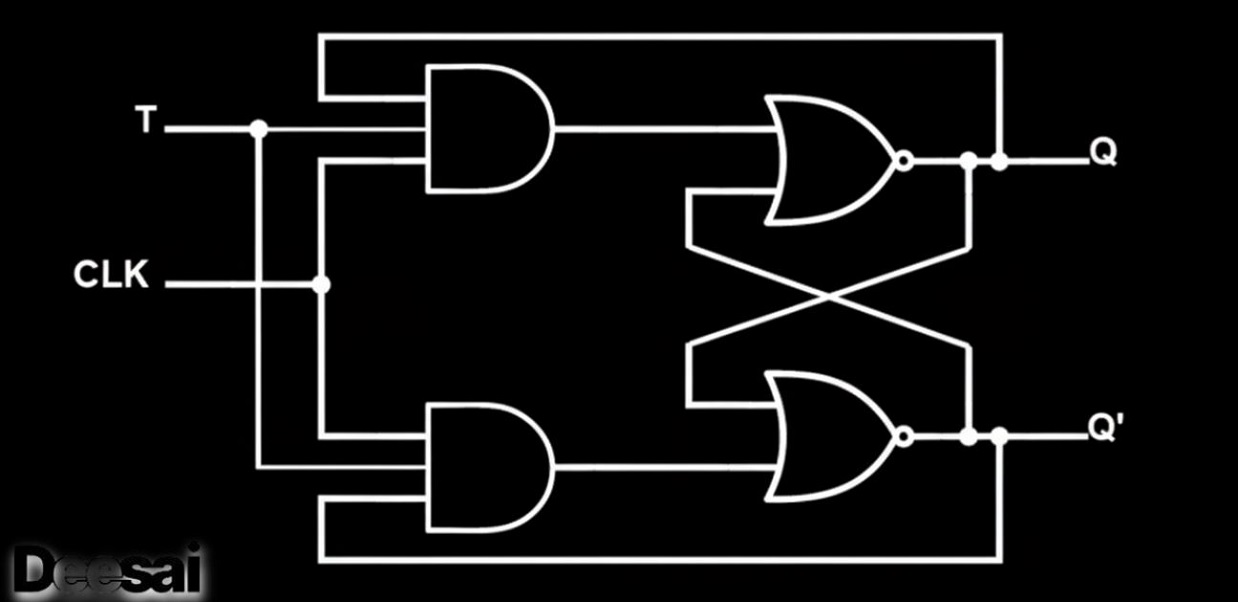

หน่วยประมวลผลประสาท (NPU) ทำงานโดยอาศัยเครือข่ายประสาทของสมอง โดยจำลองพฤติกรรมของเซลล์ประสาทและไซแนปส์ของมนุษย์ที่ชั้นวงจร วิธีนี้ช่วยให้สามารถประมวลผลชุดคำสั่งการเรียนรู้เชิงลึก ซึ่งคำสั่งหนึ่งจะประมวลผลชุดเซลล์ประสาทเสมือนให้เสร็จสมบูรณ์

ต่างจากโปรเซสเซอร์แบบดั้งเดิม NPU ไม่ได้ถูกสร้างขึ้นมาเพื่อการคำนวณที่แม่นยำ แต่ NPU ถูกสร้างขึ้นมาเพื่อฟังก์ชันการแก้ปัญหาโดยเฉพาะ และสามารถพัฒนาได้อย่างต่อเนื่อง โดยเรียนรู้จากข้อมูลและอินพุตประเภทต่างๆ ระบบ AI ที่ผสานรวม NPU ใช้ประโยชน์จากการเรียนรู้ของเครื่อง จึงสามารถนำเสนอโซลูชันที่ปรับแต่งได้ตามความต้องการได้เร็วขึ้น โดยไม่จำเป็นต้องเขียนโปรแกรมด้วยตนเองอีกต่อไป

คุณสมบัติที่โดดเด่นของ NPU คือการประมวลผลแบบขนานที่เหนือกว่า และสามารถเร่งการทำงานของ AI ผ่านคอร์ความจุสูงที่เรียบง่าย ซึ่งทำให้ไม่ต้องทำงานหลายประเภท NPU ประกอบด้วยโมดูลเฉพาะสำหรับการคูณและการบวก ฟังก์ชันการเปิดใช้งาน การดำเนินการข้อมูล 2 มิติ และการคลายการบีบอัด โมดูลการคูณและการบวกเฉพาะนี้ใช้สำหรับการดำเนินการที่เกี่ยวข้องกับการประมวลผลแอปพลิเคชันเครือข่ายประสาท เช่น การคำนวณการคูณและการบวกเมทริกซ์ การคอนโวลูชัน ผลคูณจุด และฟังก์ชันอื่นๆ

แม้ว่าโปรเซสเซอร์แบบดั้งเดิมจะต้องใช้คำสั่งนับพันคำสั่งเพื่อให้การประมวลผลนิวรอนประเภทนี้เสร็จสมบูรณ์ แต่ NPU อาจสามารถดำเนินการที่คล้ายกันนี้ให้เสร็จสมบูรณ์ได้ด้วยคำสั่งเพียงคำสั่งเดียว นอกจากนี้ NPU ยังผสานรวมการจัดเก็บข้อมูลและการคำนวณผ่านน้ำหนักซินแนปส์ ซึ่งเป็นตัวแปรการคำนวณแบบไหลลื่นที่กำหนดให้กับโหนดเครือข่าย ซึ่งบ่งชี้ความน่าจะเป็นของผลลัพธ์ที่ "ถูกต้อง" หรือ "ต้องการ" ซึ่งสามารถปรับเปลี่ยนหรือ "เรียนรู้" ได้ตลอดเวลา นำไปสู่ประสิทธิภาพการทำงานที่ดีขึ้น

แม้ว่าการพัฒนา NPU ยังคงพัฒนาอย่างต่อเนื่อง แต่การทดสอบแสดงให้เห็นว่าประสิทธิภาพของ NPU บางตัวดีกว่า GPU ที่เปรียบเทียบได้มากกว่า 100 เท่า โดยมีการใช้พลังงานเท่ากัน

ข้อได้เปรียบหลักของ NPU

หน่วยประมวลผลประสาท (NPU) ไม่ได้ถูกออกแบบหรือคาดหวังให้มาแทนที่ CPU และ GPU แบบดั้งเดิม อย่างไรก็ตาม สถาปัตยกรรมของ NPU ได้พัฒนาการออกแบบของโปรเซสเซอร์ทั้งสองตัว เพื่อให้เกิดการประมวลผลแบบขนานและการเรียนรู้ของเครื่องที่เหนือชั้นและมีประสิทธิภาพยิ่งขึ้น NPU สามารถปรับปรุงการทำงานทั่วไป (แต่เหมาะสมที่สุดสำหรับงานทั่วไปบางประเภท) เมื่อใช้ร่วมกับ CPU และ GPU แล้ว จึงมีข้อได้เปรียบที่สำคัญหลายประการเหนือระบบแบบดั้งเดิม

ข้อดีหลักๆ มีดังต่อไปนี้:

- การประมวลผลแบบขนาน: ดังที่ได้กล่าวไปแล้ว NPU สามารถแบ่งปัญหาใหญ่ๆ ออกเป็นส่วนประกอบต่างๆ เพื่อแก้ปัญหาแบบมัลติทาสก์ได้ ประเด็นสำคัญคือ แม้ว่า GPU จะมีความโดดเด่นในการประมวลผลแบบขนาน แต่โครงสร้างที่เป็นเอกลักษณ์ของ NPU ก็สามารถทำงานได้ดีกว่า GPU ที่เทียบเท่ากัน โดยใช้พลังงานน้อยลงและมีขนาดพื้นที่ใช้งานที่เล็กลง

- ประสิทธิภาพที่ดีขึ้น: แม้ว่า GPU มักจะถูกใช้สำหรับ งาน ประมวลผลประสิทธิภาพสูง และ AI แต่ NPU สามารถประมวลผลแบบขนานที่คล้ายคลึงกันได้อย่างมีประสิทธิภาพการใช้พลังงานที่ดีกว่ามาก เนื่องจาก AI และการประมวลผลประสิทธิภาพสูงอื่นๆ กลายเป็นเรื่องปกติมากขึ้นเรื่อยๆ และต้องการพลังงานมากขึ้น NPU จึงนำเสนอโซลูชันอันทรงคุณค่าสำหรับการลดการใช้พลังงานที่สำคัญ

- การประมวลผลข้อมูลมัลติมีเดียแบบเรียลไทม์: NPU ออกแบบมาเพื่อประมวลผลและตอบสนองต่อข้อมูลอินพุตที่หลากหลายยิ่งขึ้น ทั้งภาพ วิดีโอ และเสียง การนำ NPU มาเสริมประสิทธิภาพแอปพลิเคชันต่างๆ เช่น หุ่นยนต์ อุปกรณ์ อินเทอร์เน็ตในทุกสิ่ง (IoT) และอุปกรณ์สวมใส่ ช่วยให้สามารถให้ข้อมูลป้อนกลับแบบเรียลไทม์ ลดความยุ่งยากในการทำงาน และให้ข้อเสนอแนะและโซลูชันที่สำคัญเมื่อเวลาตอบสนองมีความสำคัญสูงสุด

NPU เทียบกับ GPU เทียบกับ CPU

ในโลกของวิทยาการคอมพิวเตอร์แบบคลาสสิก หน่วยประมวลผลกลาง (CPU) ถือเป็น "สมอง" ของคอมพิวเตอร์ CPU ประมวลผลงานคอมพิวเตอร์แบบดั้งเดิมส่วนใหญ่ และรับผิดชอบการใช้งานที่หลากหลาย แม้ว่าจะมี CPU หลายประเภท แต่โดยทั่วไปแล้ว CPU ทั้งหมดจะทำงานตามลำดับเชิงเส้น โดยตอบสนองต่อคำขอตามลำดับที่ส่งมา

ตั้งแต่ทศวรรษ 1950 ถึงทศวรรษ 1990 ซีพียูเป็นอุปกรณ์ที่รับหน้าที่ประมวลผลคอมพิวเตอร์แทบทุกชนิด โดยทำหน้าที่ในการสั่งการโปรแกรม ควบคุมระบบ และจัดการอินพุต/เอาต์พุต (I/O)

แอปพลิเคชันที่มีความต้องการสูงมักจะผลักดันการออกแบบ CPU รุ่นแล้วรุ่นเล่าให้ถึงขีดจำกัดของฮาร์ดแวร์ ซึ่งมักทำให้เกิดความล่าช้าอย่างมากหรือแม้กระทั่งระบบล้มเหลว แต่ด้วยการถือกำเนิดของเกมคอมพิวเตอร์ส่วนบุคคลและการออกแบบด้วยคอมพิวเตอร์ช่วย (CAD) ในช่วงทศวรรษ 1980 อุตสาหกรรมจึงต้องการโซลูชันที่รวดเร็วและมีประสิทธิภาพมากขึ้นสำหรับการเรนเดอร์กราฟิกคอมพิวเตอร์

หน่วย ประมวลผลกราฟิก (GPU) เดิมทีถูกสร้างขึ้นเพื่อถ่ายโอนภาระงานประมวลผลภาพอันหนักหน่วงจาก CPU หลัก แม้ว่า GPU มักจะใช้คอร์น้อยกว่าในการดำเนินการเชิงเส้น แต่ GPU นั้นมีคอร์นับร้อยถึงหลายพันคอร์ ซึ่งสามารถประมวลผลแบบขนานได้ ซึ่งเป็นกระบวนการที่งานขนาดใหญ่จะถูกแบ่งย่อยออกเป็นปัญหาย่อยๆ ที่สามารถแก้ไขได้พร้อมกันด้วยโปรเซสเซอร์และ/หรือคอร์หลายตัว

เดิมที GPU ได้รับการพัฒนาขึ้นเพื่อรองรับการประมวลผลวิดีโอและภาพ ความสามารถในการประมวลผลแบบขนานทำให้ฮาร์ดแวร์มีความเหมาะสมอย่างยิ่งสำหรับแอปพลิเคชันการประมวลผลอื่นๆ ที่ต้องการประสิทธิภาพสูง เช่น งานที่เกี่ยวข้องกับบล็อก เชนและ AI แม้ว่า GPU จะไม่ใช่โปรเซสเซอร์ประเภทเดียวที่สามารถประมวลผลแบบขนานหรือ การประมวลผลแบบขนานได้แต่ก็เหมาะอย่างยิ่งสำหรับการประมวลผลแบบขนาน อย่างไรก็ตาม GPU ก็มีข้อจำกัดเช่นกัน และมักต้องการการใช้พลังงานที่สูงมากเพื่อทำงานที่ต้องการประสิทธิภาพสูงกว่า GPU มีประสิทธิภาพการทำงานที่สูงขึ้นมาพร้อมกับต้นทุนด้านพลังงานที่สูงขึ้น

NPU และตัวเร่งความเร็ว AI อื่นๆ นำเสนอทางเลือกที่มีประสิทธิภาพมากกว่า NPU ที่ออกแบบมาเฉพาะสำหรับการดำเนินงาน AI ผสานรวมและปรับปรุงการประมวลผลแบบขนานขั้นสูงของ GPU เข้าด้วยกัน จึงมอบประสิทธิภาพสูงพร้อมการใช้พลังงานที่ต่ำลง (และข้อดีเพิ่มเติมคือขนาดพื้นที่ทางกายภาพที่เล็กลง)

การเปรียบเทียบโปรเซสเซอร์

- หน่วยประมวลผลกลาง: “สมอง” ของคอมพิวเตอร์ โดยทั่วไปแล้วซีพียูจะจัดสรรทรานซิสเตอร์ภายในประมาณ 70% เพื่อสร้างหน่วยความจำแคช และเป็นส่วนหนึ่งของหน่วยควบคุมของคอมพิวเตอร์ ซีพียูมีจำนวนคอร์ค่อนข้างน้อย ใช้สถาปัตยกรรมการประมวลผลแบบอนุกรมสำหรับการแก้ปัญหาเชิงเส้น และออกแบบมาเพื่อการควบคุมตรรกะที่แม่นยำ

- หน่วยประมวลผลกราฟิก: เดิมที GPU พัฒนาขึ้นเพื่อประมวลผลภาพและวิดีโอ GPU มีแกนประมวลผลมากกว่า CPU มาก และใช้ทรานซิสเตอร์ส่วนใหญ่ในการสร้างหน่วยประมวลผลหลายหน่วย ซึ่งแต่ละหน่วยมีความซับซ้อนในการประมวลผลต่ำ ช่วยให้สามารถประมวลผลแบบขนานขั้นสูงได้ GPU เหมาะสำหรับเวิร์กโหลดที่ต้องการการประมวลผลข้อมูลขนาดใหญ่ และยังมีประโยชน์เพิ่มเติมอย่างมากในการประมวลผลข้อมูลขนาดใหญ่ ศูนย์เซิร์ฟเวอร์แบ็กเอนด์ และแอปพลิเคชันบล็อกเชน

- หน่วยประมวลผลประสาท: หน่วยประมวลผลกลาง (NPU) พัฒนาต่อยอดจากการประมวลผลแบบขนานของ GPU โดยใช้สถาปัตยกรรมคอมพิวเตอร์ที่ออกแบบมาเพื่อจำลองเซลล์ประสาทในสมองมนุษย์ เพื่อมอบประสิทธิภาพการทำงานที่มีประสิทธิภาพสูง NPU ใช้น้ำหนักซินแนปส์เพื่อผสานรวมฟังก์ชันการจัดเก็บหน่วยความจำและการคำนวณเข้าด้วยกัน ซึ่งบางครั้งอาจให้ผลลัพธ์ที่มีความแม่นยำน้อยกว่าและมีความหน่วงต่ำมาก แม้ว่า CPU จะออกแบบมาเพื่อการประมวลผลเชิงเส้นที่แม่นยำ แต่ NPU ถูกสร้างขึ้นมาเพื่อการเรียนรู้ของเครื่อง ส่งผลให้การทำงานแบบมัลติทาสก์ การประมวลผลแบบขนาน และความสามารถในการปรับเปลี่ยนและปรับแต่งการทำงานได้ตลอดเวลาโดยไม่จำเป็นต้องเขียนโปรแกรมเพิ่มเติม

กรณีการใช้งาน NPU

เนื่องจากเป็นเทคโนโลยีใหม่ที่เกิดขึ้น ผู้ผลิตคอมพิวเตอร์และฮาร์ดแวร์ชั้นนำหลายราย รวมถึง Microsoft, Intel, Nvidia, Qualcomm และ Samsung จึงนำเสนอหน่วยประมวลผลประสาท (NPU) แบบสแตนด์อโลนหรือแบบรวม เช่น Apple Neural Engine

การนำ NPU มาใช้ในอุปกรณ์อิเล็กทรอนิกส์ระดับผู้บริโภคมีประโยชน์มากมาย เช่น การรับรู้ภาพที่ดีขึ้น และการปรับแต่งกล้องที่ใช้ AI ให้เบลอพื้นหลังในวิดีโอคอลได้ดีขึ้น แอปพลิเคชันเพิ่มเติมสำหรับ NPU มีดังนี้

ปัญญาประดิษฐ์และโมเดลภาษาขนาดใหญ่

ในฐานะตัวเร่งความเร็ว AI ประเภทหนึ่ง NPU ถูกสร้างขึ้นเพื่อพัฒนาประสิทธิภาพของระบบ AI และ ML เช่น เครือข่ายประสาทเทียม การทำงานแบบขนานที่ปรับปรุงขึ้นของ NPU เปรียบเสมือนการเสริม GPU มอบการพัฒนาที่สำคัญสำหรับ โมเดลภาษาขนาดใหญ่ ที่ต้องการการประมวลผลแบบปรับตัวที่มีความหน่วงต่ำเพื่อตีความสัญญาณมัลติมีเดีย ดำเนินการจดจำเสียงพูด และสร้างภาษาธรรมชาติและศิลปะที่ใช้ในเครื่องมือต่างๆ เช่น แชทบอท AI และแอ ปพลิเคชันภาพและวิดีโอ AI แบบสร้างภาพ

อุปกรณ์อินเทอร์เน็ตของสรรพสิ่ง (IoT)

ด้วยการประมวลผลแบบขนานและความสามารถในการเรียนรู้ด้วยตนเองที่โดดเด่น NPU จึงเหมาะอย่างยิ่งสำหรับอุปกรณ์ IoT ในเครือข่าย เช่น อุปกรณ์สวมใส่ ผู้ช่วยเสียง และอุปกรณ์อัจฉริยะ

ศูนย์ข้อมูล

AI และการเรียนรู้ของเครื่องจักรเป็นประโยชน์อย่างมากสำหรับศูนย์ข้อมูลที่ต้องการเพิ่มประสิทธิภาพการใช้ทรัพยากรพลังงาน NPU ประสิทธิภาพสูงและประหยัดพลังงานมอบคุณค่ามหาศาลสำหรับศูนย์ข้อมูลที่นำเสนอการจัดการทรัพยากรที่ดีขึ้นสำหรับ การประมวลผลแบบค ลาว ด์

รถยนต์ไร้คนขับ

ยานยนต์ไร้คนขับ เช่น โดรน หรือรถยนต์และรถบรรทุกขับเคลื่อนอัตโนมัติ ได้รับประโยชน์อย่างมากจากความสามารถในการประมวลผลแบบเรียลไทม์ของ NPU ช่วยให้สามารถแก้ไขเส้นทางได้เร็วขึ้นและดีขึ้นโดยอาศัยข้อมูลจากเซ็นเซอร์มัลติมีเดีย ด้วยการประมวลผลแบบขนานที่เหนือชั้น NPU สามารถช่วยให้ยานยนต์ไร้คนขับตีความและประมวลผลข้อมูลที่กำลังพัฒนาอย่างรวดเร็ว เช่น ป้ายจราจร รูปแบบการจราจร และแม้แต่สิ่งกีดขวางที่ไม่คาดคิด

การประมวลผลแบบเอจและเอจเอไอ

แม้ว่าคลาวด์คอมพิวติ้งจะนำเสนอโซลูชันข้อมูลและทรัพยากรนอกสถานที่ขั้นสูงสำหรับ IoT อุปกรณ์อัจฉริยะ และอุปกรณ์คอมพิวเตอร์ส่วนบุคคลอื่นๆ แต่ เอจคอมพิวติ้ง และ เอจเอไอ (edge AI) มุ่งหวังที่จะนำข้อมูลสำคัญและทรัพยากรการประมวลผลมาไว้ใกล้ผู้ใช้มากขึ้น วิธีนี้ช่วยลดความหน่วง ลดการใช้พลังงาน และเสริมสร้างความเป็นส่วนตัว NPU ซึ่งใช้พลังงานน้อยลงและมีขนาดเล็กลง กำลังกลายเป็นองค์ประกอบสำคัญในเอจคอมพิวติ้งและเอจเอไอบนอุปกรณ์

หุ่นยนต์

ด้วยความเชี่ยวชาญในการจัดการงานที่ต้องใช้การเรียนรู้ของเครื่องจักรและคอมพิวเตอร์วิชัน NPU จึงให้การสนับสนุนที่สำคัญต่อการพัฒนาอุตสาหกรรมหุ่นยนต์ หุ่นยนต์ที่ใช้ AI ตั้งแต่ผู้ช่วยในบ้านไปจนถึงเครื่องมือผ่าตัดอัตโนมัติ ล้วนอาศัย NPU เพื่อพัฒนาความสามารถในการตรวจจับ เรียนรู้ และตอบสนองต่อสภาพแวดล้อม

ผลิตภัณฑ์

December 20, 2025

หน่วยประมวลผลประสาทอธิบาย

ค้นพบคำจำกัดความและฟังก์ชันของหน่วยประมวลผลประสาท (NPU)

by

นักเขียนบทความ